Niedawno jeden z naszych czytelników poprosił nas o wskazówki, jak zoptymalizować plik robots.txt w celu poprawy SEO.

Plik Robots.txt mówi wyszukiwarkom, jak indeksować twoją witrynę, co czyni ją niesamowicie potężnym narzędziem SEO.

W tym artykule pokażemy, jak stworzyć doskonały plik robots.txt dla SEO.

Co to jest plik robots.txt?

Robots.txt to plik tekstowy, który właściciele witryn mogą tworzyć, aby poinformować roboty wyszukiwarek, jak mają pobierać i indeksować strony w ich witrynie.

Zwykle jest przechowywany w katalogu głównym witryny, zwanym również folderem głównym. Podstawowy format pliku robots.txt wygląda następująco:

User-agent: [nazwa klienta użytkownika] Disallow: [ciąg adresu URL nie do indeksowania] User-agent: [nazwa klienta użytkownika] Zezwól: [ciąg adresu URL do indeksowania] Mapa witryny: [adres URL mapy witryny XML]

Możesz mieć wiele wierszy instrukcji, aby zezwolić lub zabronić określonych adresów URL i dodać wiele map witryn. Jeśli nie zablokujesz dostępu do adresu URL, roboty wyszukiwarek przyjmą, że mogą go indeksować.

Oto jak może wyglądać przykładowy plik robots.txt:

Agent użytkownika: * Zezwól: / wp-content / uploads / Disallow: / wp-content / plugins / Disallow: / wp-admin / Mapa witryny: https://example.com/sitemap_index.xml

W powyższym przykładzie robots.txt zezwoliliśmy wyszukiwarkom na przeszukiwanie i indeksowanie plików w naszym folderze przesyłania plików WordPress.

Następnie zabroniliśmy robotom wyszukującym pobierania i indeksowania wtyczek oraz folderów administracyjnych WordPress.

Na koniec podaliśmy adres URL naszej mapy witryny XML.

Czy potrzebujesz pliku Robots.txt do swojej witryny WordPress?

Jeśli nie masz pliku robots.txt, wyszukiwarki nadal będą przeszukiwać i indeksować Twoją witrynę. Nie będziesz jednak w stanie powiedzieć wyszukiwarkom, których stron lub folderów nie powinny indeksować.

Nie będzie to miało większego wpływu, gdy po raz pierwszy założysz bloga i nie będziesz mieć zbyt wielu treści.

Jednak gdy Twoja witryna rozrasta się i masz dużo treści, prawdopodobnie chciałbyś mieć lepszą kontrolę nad tym, jak Twoja witryna jest przeszukiwana i indeksowana.

Oto dlaczego.

Boty wyszukiwania mają limit indeksowania dla każdej witryny.

Oznacza to, że indeksują określoną liczbę stron podczas sesji indeksowania. Jeśli nie zakończą indeksowania wszystkich stron w Twojej witrynie, wrócą i wznowią indeksowanie w następnej sesji.

Może to spowolnić szybkość indeksowania witryny.

Możesz to naprawić, uniemożliwiając robotom wyszukującym próby indeksowania niepotrzebnych stron, takich jak strony administratora WordPress, pliki wtyczek i folder motywów.

Blokując niepotrzebne strony, oszczędzasz swój limit indeksowania. Pomaga to wyszukiwarkom indeksować jeszcze więcej stron w Twojej witrynie i indeksować je tak szybko, jak to możliwe.

Innym dobrym powodem korzystania z pliku robots.txt jest chęć zatrzymania wyszukiwarek przed indeksowaniem postu lub strony w Twojej witrynie.

Nie jest to najbezpieczniejszy sposób na ukrycie treści przed opinią publiczną, ale pomoże Ci to zapobiec ich pojawianiu się w wynikach wyszukiwania.

Jak wygląda idealny plik Robots.txt?

Wiele popularnych blogów używa bardzo prostego pliku robots.txt. Ich zawartość może się różnić w zależności od potrzeb konkretnej witryny:

Agent użytkownika: * Zakazać: Mapa witryny: http://www.example.com/post-sitemap.xml Mapa witryny: http://www.example.com/page-sitemap.xml

Ten plik robots.txt umożliwia wszystkim robotom indeksowanie całej treści i zapewnia im łącze do map witryn XML witryny.

W przypadku witryn WordPress zalecamy następujące reguły w pliku robots.txt:

Agent użytkownika: * Zezwól: / wp-content / uploads / Disallow: / wp-content / plugins / Disallow: / wp-admin / Disallow: /readme.html Disallow: / refer / Mapa witryny: http://www.example.com/post-sitemap.xml Mapa witryny: http://www.example.com/page-sitemap.xml

To nakazuje robotom wyszukiwania indeksowanie wszystkich obrazów i plików WordPress. Zabrania robotom wyszukiwania indeksowania plików wtyczek WordPress, obszaru administracyjnego WordPress, pliku readme WordPress i linków partnerskich.

Dodając mapy witryn do pliku robots.txt, ułatwiasz robotom Google znajdowanie wszystkich stron w Twojej witrynie.

Teraz, gdy już wiesz, jak wygląda idealny plik robots.txt, przyjrzyjmy się, jak możesz utworzyć plik robots.txt w WordPress.

Jak utworzyć plik Robots.txt w WordPress?

Istnieją dwa sposoby tworzenia pliku robots.txt w WordPress. Możesz wybrać metodę, która najbardziej Ci odpowiada.

Metoda 1: Edycja pliku Robots.txt przy użyciu wszystkiego w jednym SEO

All in One SEO znany również jako AIOSEO to najlepsza wtyczka WordPress SEO na rynku używana przez ponad 2 miliony stron internetowych.

Jest łatwy w użyciu i zawiera generator plików robots.txt.

Jeśli nie masz jeszcze zainstalowanej wtyczki AIOSEO, możesz zapoznać się z naszym przewodnikiem krok po kroku, jak zainstalować wtyczkę WordPress .

Uwaga: Bezpłatna wersja AIOSEO jest również dostępna i ma tę funkcję.

Po zainstalowaniu i aktywowaniu wtyczki możesz jej używać do tworzenia i edytowania pliku robots.txt bezpośrednio z obszaru administracyjnego WordPress.

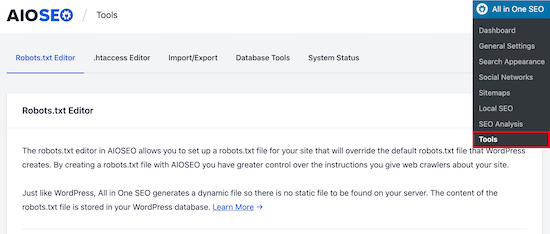

Po prostu przejdź do Wszystko w jednym SEO »Narzędzia , aby edytować plik robots.txt.

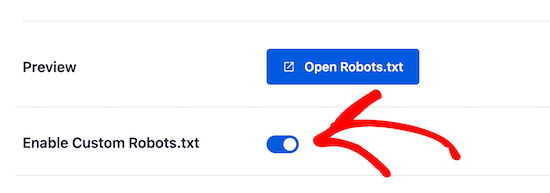

Najpierw musisz włączyć opcję edycji, klikając przełącznik „Włącz niestandardowy plik robots.txt” na niebieski.

Po włączeniu tego przełącznika możesz utworzyć niestandardowy plik robots.txt w WordPress.

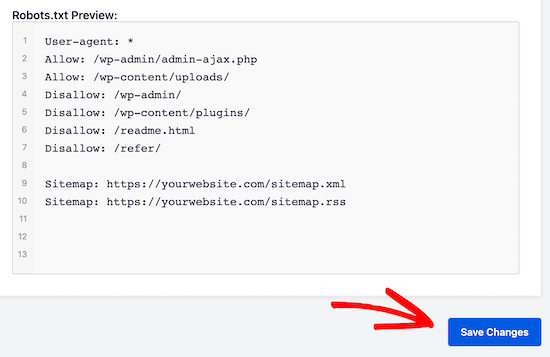

Wszystko w jednym SEO pokaże istniejący plik robots.txt w sekcji „Podgląd robots.txt” u dołu ekranu.

Ta wersja pokaże domyślne reguły dodane przez WordPress.

Te domyślne reguły informują wyszukiwarki, że mają nie indeksować podstawowych plików WordPress, pozwalają robotom indeksować całą zawartość i udostępniają im łącze do map witryn XML w Twojej witrynie.

Teraz możesz dodać własne reguły niestandardowe, aby ulepszyć plik robots.txt pod kątem SEO.

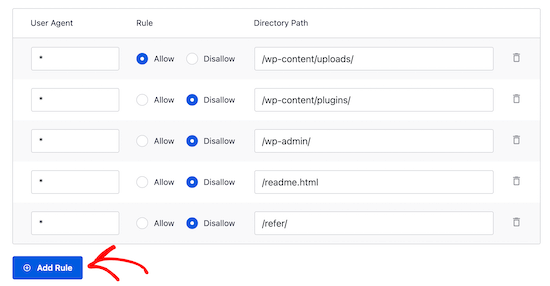

Aby dodać regułę, wprowadź klienta użytkownika w polu „Agent użytkownika”. Użycie * spowoduje zastosowanie reguły do wszystkich klientów użytkownika.

Następnie wybierz, czy chcesz „Zezwól” czy „Zabronić” wyszukiwarkom indeksowania.

Następnie wprowadź nazwę pliku lub ścieżkę do katalogu w polu „Ścieżka katalogu”.

Reguła zostanie automatycznie zastosowana do pliku robots.txt. Aby dodać kolejną regułę, kliknij przycisk „Dodaj regułę”.

Zalecamy dodawanie reguł do czasu utworzenia idealnego formatu pliku robots.txt, który udostępniliśmy powyżej.

Twoje reguły niestandardowe będą wyglądać tak.

Po zakończeniu nie zapomnij kliknąć przycisku „Zapisz zmiany”, aby zapisać zmiany.

Metoda 2. Edytuj plik Robots.txt ręcznie przy użyciu protokołu FTP

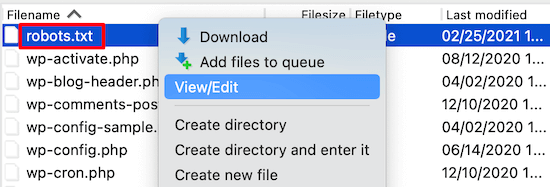

W przypadku tej metody musisz użyć klienta FTP do edycji pliku robots.txt.

Po prostu połącz się ze swoim kontem hostingu WordPress przy użyciu klienta FTP.

Po wejściu do środka będziesz mógł zobaczyć plik robots.txt w folderze głównym swojej witryny.

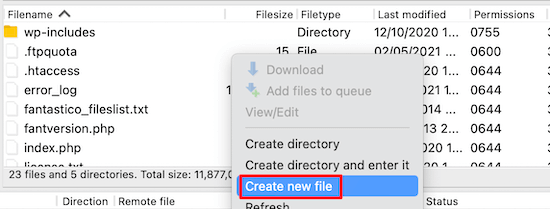

Jeśli go nie widzisz, prawdopodobnie nie masz pliku robots.txt.

W takim przypadku możesz po prostu go utworzyć.

Robots.txt to zwykły plik tekstowy, co oznacza, że można go pobrać na komputer i edytować za pomocą dowolnego edytora zwykłego tekstu, takiego jak Notatnik lub TextEdit.

Po zapisaniu zmian możesz przesłać je z powrotem do folderu głównego swojej witryny.

Jak przetestować plik Robots.txt?

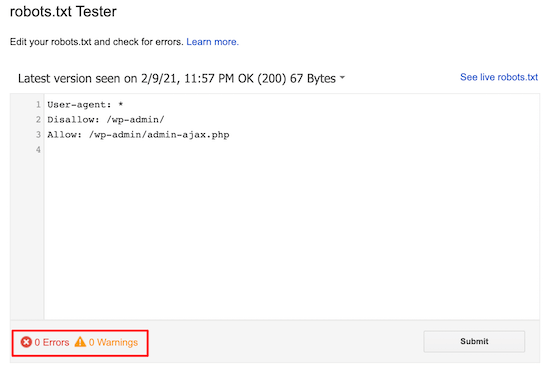

Po utworzeniu pliku robots.txt zawsze warto przetestować go za pomocą narzędzia do testowania pliku robots.txt.

Istnieje wiele narzędzi do testowania pliku robots.txt, ale zalecamy użycie tego znajdującego się w Google Search Console .

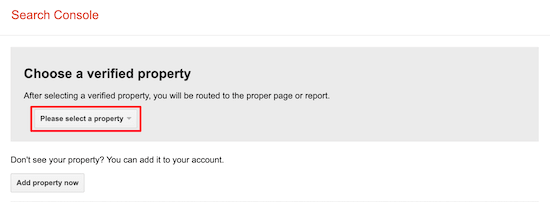

Najpierw musisz połączyć swoją witrynę z Google Search Console. Jeśli jeszcze tego nie zrobiłeś, zapoznaj się z naszym przewodnikiem na temat dodawania witryny WordPress do Google Search Console .

Następnie możesz użyć narzędzia do testowania robotów Google Search Console .

Po prostu wybierz swoją nieruchomość z listy rozwijanej.

Narzędzie automatycznie pobierze plik robots.txt Twojej witryny i podświetli błędy oraz ostrzeżenia, jeśli takie znalazło.

Ostatnie myśli

Celem optymalizacji pliku robots.txt jest uniemożliwienie wyszukiwarkom indeksowania stron, które nie są publicznie dostępne. Na przykład strony w folderze wp-plugins lub strony w folderze administratora WordPress.

Powszechnym mitem wśród ekspertów SEO jest to, że blokowanie kategorii WordPress, tagów i stron archiwalnych poprawi szybkość indeksowania i spowoduje szybsze indeksowanie i wyższą pozycję w rankingu.

To nieprawda. Jest to również sprzeczne ze wskazówkami Google dla webmasterów.

Zalecamy stosowanie powyższego formatu robots.txt do tworzenia pliku robots.txt dla swojej witryny internetowej.

Mamy nadzieję, że ten artykuł pomógł Ci dowiedzieć się, jak zoptymalizować plik robots.txt WordPress pod kątem SEO. Możesz także chcieć zapoznać się z naszym ostatecznym przewodnikiem po SEO WordPress i najlepszymi narzędziami SEO WordPress , aby rozwinąć swoją witrynę.

Jeśli podobał Ci się ten artykuł, zasubskrybuj nasz kanał YouTube z samouczkami wideo WordPress. Możesz nas również znaleźć na Twitterze i Facebooku .